万物为大家提供一个基本的AI算法盒子组装教程,适用于想要自己动手搭建一个 AI边缘计算平台系统的客户或开发者。请注意,具体步骤可能会因使用的硬件和软件平台而有所不同。

1. 计算平台:算能BM1684边缘盒(或Raspberry Pi)、NVIDIA Jetson Nano等小型计算机。

2. 摄像头模块:USB摄像头或专用摄像头模块。

3. 存储设备:MicroSD卡(用于安装操作系统)。

4. 电源供应:适合所选计算平台的电源适配器。

5. 外壳:根据需要选择合适的保护壳。

6. 配件:HDMI线、显示器、键盘、鼠标等(用于初始设置)。

7. 软件:操作系统(如Raspbian)、编程语言(如Python)、深度学习框架(如TensorFlow Lite或PyTorch)。

1. 准备操作系统

- 下载适合您计算平台的操作系统镜像文件,如Raspbian。

- 使用工具(如Etcher)将操作系统镜像写入MicroSD卡。

2. 硬件连接

- 将MicroSD卡插入计算平台。

- 连接摄像头模块到计算平台上的相应接口。

- 连接显示器、键盘和鼠标,以便进行初始配置。

- 接通电源,启动计算平台。

3. 系统配置

- 按照屏幕提示完成操作系统的初始设置,如网络配置、用户账户创建等。

- 更新系统软件包,确保所有组件都是最新的:

```

sudo apt-get update

sudo apt-get upgrade

```

4. 安装开发环境

- 安装必要的开发工具和库,如Python及其相关库:

```

sudo apt-get install python3-pip

pip3 install numpy opencv-python

```

- 安装深度学习框架,例如TensorFlow Lite:

```

pip3 install tflite-runtime

```

5. 下载预训练模型

- 从互联网上下载预训练的算法识别模型,或者自己训练一个模型。

- 将模型文件保存到计算平台的适当位置。

6. 编写识别代码

- 使用Python或其他编程语言编写代码,加载预训练模型,并实现图像捕获和分类逻辑。

- 示例代码片段(使用TensorFlow Lite):

```

import cv2

import tflite_runtime.interpreter as tflite

# 加载模型

interpreter = tflite.Interpreter(model_path="model.tflite")

interpreter.allocate_tensors()

# 获取输入输出张量信息

input_details = interpreter.get_input_details()

output_details = interpreter.get_output_details()

# 打开摄像头

cap = cv2.VideoCapture(0)

while True:

ret, frame = cap.read()

if not ret:

break

# 预处理图像

input_data = preprocess_image(frame, input_details[0]['shape'])

# 设置输入张量

interpreter.set_tensor(input_details[0]['index'], input_data)

# 运行推理

interpreter.invoke()

# 获取输出张量

output_data = interpreter.get_tensor(output_details[0]['index'])

prediction = output_data.argmax()

# 显示预测结果

print("Predicted class:", prediction)

# 显示视频流

cv2.imshow('frame', frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

# 清理资源

cap.release()

cv2.destroyAllWindows()

```

7. 测试与调试

- 运行您的程序,检查摄像头是否正常工作,模型是否能正确识别各种识别算法。

- 根据测试结果调整代码或模型参数,以提高识别准确率。

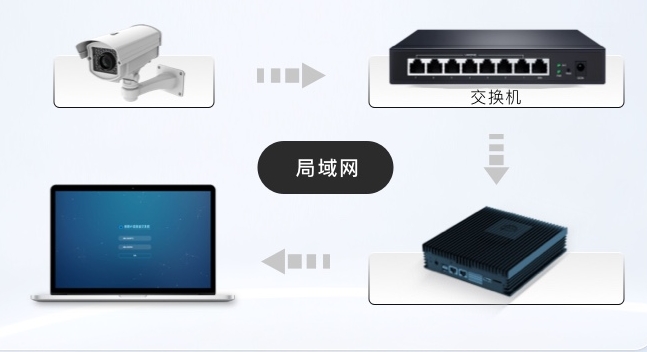

8. 部署

- 当一切运行良好后,您可以断开显示器、键盘和鼠标,将计算平台放入外壳中,仅通过网络或API接口进行远程控制。

9. 持续优化

- 收集更多的训练数据,定期更新模型,以适应新的算法种类或环境变化。

通过以上步骤,您就可以成功组装一个AI算法盒子,用于边缘计算场景使用了。希望这个教程对您有所帮助!如果有任何具体的技术问题,欢迎随时联系万物纵横。

需求留言:

需求留言: